Personajes

Personajes

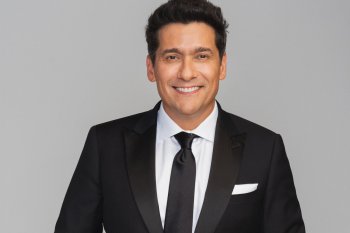

Felipe Torres, chileno de OpenAI: “La IA, como cualquier tecnología potente, tiene riesgos y beneficios inherentes”

Felipe Torres, chileno de OpenAI: “La IA, como cualquier tecnología potente, tiene riesgos y beneficios inherentes”

El ingeniero de software vivió en primera persona la crisis interna de la compañía en noviembre pasado, y hace una semana experimentó las repercusiones del mega-anuncio que realizó la startup. Se trata de Sora, el software dedicado a la generación de videos con inteligencia artificial que promete revolucionar la industria de producción audiovisual. Acá, el programador habla sobre su experiencia trabajando en la empresa y opina sobre los debates éticos de esta tecnología. “La IA debe aumentar las capacidades humanas, no sustituirlas”, afirma desde San Francisco, California.

-

Cuéntale a tus contactos

-

Recomiéndalo en tu red profesional

-

Cuéntale a todos

-

Cuéntale a tus amigos

-

envíalo por email

La semana pasada OpenAI, empresa cofundada por Sam Altman y conocida por su producto estrella ChatGPT, volvió a copar las portadas de periódicos internacionales con el anuncio de Sora, el software de creación de videos en base a inteligencia artificial que promete revolucionar la industria de la producción audiovisual.

A pocos minutos del estreno del programa, aparecieron miles de posteos en X de usuarios probando la nueva herramienta. Con sólo un comando básico, la plataforma creaba -en menos de un minuto- videos HD que parecían producidos por los mejores estudios cinematográficos de Hollywood.

Detrás de todo esto hubo un grupo de casi 800 personas que vieron estos acontecimientos en primera fila: los trabajadores de OpenAI. Y uno de ellos es chileno. Se llama Felipe Torres y ejerce como miembro del staff técnico en el equipo de Datos Humanos de la compañía, la cual está valorada en US$ 80.000 millones.

“En términos muy sencillos, gestionamos y desarrollamos la infraestructura necesaria para recopilar datos humanos que los investigadores pueden utilizar para explorar, validar hipótesis y, en última instancia, mejorar nuestros modelos de IA. Mi papel se ha centrado en mejorar la experiencia de los usuarios de nuestra plataforma, así como la eficiencia de la misma, para que podamos obtener una mejor calidad de datos para varios modelos diferentes”, describe.

Felipe Torres no tiene un recuerdo específico de cuándo se empezó a interesar en la industria tecnológica. Pero si piensa detenidamente, llega a una escena de su niñez: “Mi hermano y yo solíamos acompañar a mi padre cuando se iba a la oficina un fin de semana y nos dejaba jugar en su computador (o en el de sus colegas). Al principio jugábamos sobre todo a juegos de Windows 3.11 (SkiFree, Solitario), pero en cuanto empezamos a navegar por Internet, me enganché”.

A partir de ahí, no hubo vuelta atrás. Torres se convirtió en un amante de pantallas, cables y videojuegos. Cuando salió del colegio entró a ingeniería civil industrial en la Universidad del Desarrollo, pero duró sólo dos años. “Después de tomar algunas clases relacionadas con la programación, me di cuenta de que no me gustaban mucho las perspectivas profesionales de la carrera”, enfatiza. Por eso, un año después, entró a ingeniería en informática en Inacap.

Desde su egreso en 2014, estuvo en una serie de startups, como Groupon, NoiseGrasp y Axiom Zen. También fundó, en 2015, Noders, una comunidad de programadores latinoamericanos.

“El trabajo comunitario me abrió los ojos al lado ‘humano’ de la ingeniería de software. Fue un periodo increíble que me puso en contacto con gente de todo el mundo. A través de estas conexiones, me ofrecieron un trabajo en Segment (startup dedicada a la inteligencia de mercado que fue adquirida por Twilio por US$ 3,2 billones en 2020), y fue entonces cuando me mudé a San Francisco, California”.

Luego de Segment, se cambió a Brex, unicornio norteamericano dedicado a la industria financiera. Ahí estuvo casi cuatro años, hasta que uno de sus jefes que había migrado a OpenAI, lo motivó a que postulara. “Al principio, desconfiaba un poco, no sabía si se trataba de una startup sobrevalorada. Pero cuanto más hablaba con amigos y gente que trabaja allí, más interesante me parecía el reto. Y eso me bastó para tomar la decisión”, señala.

Desde que la inteligencia artificial generativa se popularizó a fines de 2022 con la irrupción de ChatGPT, han surgido diversos debates éticos sobre una serie de puntos: desarrollos de contenidos falsos y engañosos, violaciones a la privacidad, creación y uso de elementos inapropiados, y falta de claridad sobre quién es responsable del contenido generado.

Sobre esto, Torres afirma que las consideraciones éticas incluyen, entre otros elementos, “abordar la parcialidad para evitar que la IA favorezca o desfavorezca injustamente a determinados grupos. La protección de la intimidad también es crucial, ya que la inteligencia artificial suele utilizar datos personales, que deben manejarse con responsabilidad. Esta tecnología también debe aumentar las capacidades humanas, no sustituirlas, y su desarrollo debe contar con la participación de un amplio abanico de personas para garantizar que sirva a los intereses generales de la sociedad”.

Y añade: “Creo que la inteligencia artificial, como cualquier tecnología potente, tiene sus riesgos y beneficios inherentes. El riesgo de la IA reside en su posible uso indebido o en sus consecuencias imprevistas. Los sistemas de IA pueden funcionar a veces de forma impredecible y, por ejemplo, reforzar los sesgos existentes en sus datos de entrenamiento, lo que es especialmente preocupante en aplicaciones como el reconocimiento facial o la toma de decisiones en sectores críticos como la política o la educación”.

“Un gran poder conlleva una gran responsabilidad”

- ¿Cómo ves el futuro de la inteligencia artificial en la próxima década, tanto en términos de avances tecnológicos como de impacto social?

- Tecnológicamente, creo que habrá grandes avances en áreas como la comprensión del lenguaje natural, el análisis predictivo y los sistemas autónomos. La IA será más eficiente, interpretable y capaz de razonamientos complejos, lo que mejorará su funcionamiento en diversos sectores como la sanidad, el transporte, la minería, la educación, etc. Sin embargo, este impacto positivo no está exento de dificultades. Los problemas de seguridad o las brechas socioeconómicas, donde el acceso a la tecnología de la IA puede ser desigual entre los distintos grupos sociales, son cuestiones importantes. La privacidad es otra preocupación crítica, ya que los datos necesarios para entrenar los sistemas pueden invadir la intimidad personal si no se manejan de forma responsable.

- ¿Y cómo percibes la relación entre los humanos y la IA? ¿Hay algún aspecto que te entusiasme o preocupe especialmente?

- Puede que sea demasiado friki decirlo, pero ver la evolución de la tecnología y nuestra relación con ella suele ser como estar dentro de una película de ciencia ficción. Sin embargo, esto no quiere decir que no haya cosas a las que tengamos que estar atentos. La idea de que los sistemas de IA tomen decisiones que podrían tener un impacto significativo en la vida de las personas, sin contar con un humano en el bucle, o sin captar los matices de la comprensión y la empatía humanas, no es lo ideal, y es algo en lo que estamos trabajando.

Cuestiones como la privacidad, la vigilancia, los prejuicios de la IA, son cosas en las que pienso mucho. Es un recordatorio de que un gran poder conlleva una gran responsabilidad, y tenemos que ir siempre por el lado de la seguridad. Nos encontramos en el umbral de una nueva era, y nuestro enfoque de esta relación entre la IA y el ser humano probablemente configurará el futuro de manera profunda.