Cómo cuido mis lucas

Cómo cuido mis lucas

De lo que es capaz la inteligencia artificial, según Fintualist

De lo que es capaz la inteligencia artificial, según Fintualist

El equipo de Fintualist, el medio de la fintech chilena Fintual, escribe en esta edición de DF MAS sobre inteligencia artificial.

-

Cuéntale a tus contactos

-

Recomiéndalo en tu red profesional

-

Cuéntale a todos

-

Cuéntale a tus amigos

-

envíalo por email

2023, el año de la IA (Generativo)

Decir que este ha sido el año de la inteligencia artificial (IA) es decir poco. En cosa de semanas, ChatGPT logró que más de 100 millones de personas pasaran de ver la IA como algo sacado de la ciencia ficción, a conversar directa y diariamente con una gracias a un simple y ubicuo chat.

Pero no fue solamente el éxito de una interfaz amigable lo que catapultó GPT al estrellato. Su potencia aumentó: su tamaño ha crecido y ya va por sobre los cientos de billones de variables (y se dice que GPT-5 superaría el trillón). Y no sólo es eso, ya que con este crecimiento, nuevas capacidades mucho más allá del simple análisis de texto y regurgitación de datos están emergiendo a paso acelerado. Como dijo Julio César, la suerte ya está echada, ya cruzamos el Rubicón.

¿De qué habilidades estamos hablando?

En el mundillo de la inteligencia artificial, un término ha empezado a sonar cada vez más y es el de las “Habilidades emergentes”. En física, un comportamiento emergente es cuando cambios pequeños en un sistema, al pasar cierto nivel, modifican sustantivamente sus propiedades cualitativas (como cuando el agua, al pasar un nivel de temperatura, se evapora).

Algo parecido pasa en una red neuronal: se entiende como una capacidad que emerge de manera no previsible cuando se aumenta su escala sobre ciertos niveles, superando las capacidades para las que estaba diseñada originalmente.

Por ejemplo, el poder resolver acertijos lógicos era imposible en las primeras versiones de GPT, pero sus últimas versiones (GPT-3.5 y GPT-4) han mostrado capacidad de resolverlos con competencia casi humana.

Dentro de estas nuevas capacidades (se han citado más de 130 en los últimos estudios) figuran elementos como el razonamiento en pasos, la aritmética, la lógica espacial, el uso de herramientas digitales, entre muchos otros. Incluso investigadores han visto la capacidad de manejar dialectos poco comunes (como el darija marroqui, del cual GPT casi no posee datos de entrenamiento).

Considerando que estos modelos son solamente entrenados con lenguaje y que lo que hacen es básicamente predecir la siguiente palabra más probable, es sorprendente que lleguen a razonamientos tan sofisticados: ratifican que el gran invento de la humanidad fue y sigue siendo el desarrollo del lenguaje.

Y aunque hay un sano escepticismo en la comunidad científica sobre estos fenómenos, la pregunta sobre qué será capaz de hacer un modelo como GPT al crecer está en el aire.

Muéstrame tu unicornio

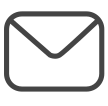

Esta misma pregunta se hizo el investigador de inteligencia artificial Sebastien Bubeck, quien tuvo acceso al modelo de GPT-4 meses antes de que fuese público. En su charla Sparks of AGI (traducida como “Chispas de inteligencia artificial general”) hizo un experimento muy interesante llamado el “test del unicornio”: esta prueba consiste en pedirle al modelo que dibuje un boceto de un unicornio, empleando un lenguaje de programación muy simple basado en definir figuras geométricas básicas (el lenguaje se llama TikZ).

A primera vista, no suena tan impresionante. Hoy existen modelos de IA generativa entrenadas con una gigante base de datos de imágenes: Midjourney en segundos crea cuadros fotorrealistas de lo que se te ocurra, pero acá el desafío es distinto. Para que un modelo de texto (un modelo que es ciego, no ve) pueda dibujar, tiene que razonar y abstraer sólo a partir de palabras qué es un unicornio en su forma más básica (un cuerpo, piernas, una cabeza y un cuerno) y ser capaz de decidir qué figuras geométricas las pueden representar, su tamaño y estimar las coordenadas de su ubicación en el espacio.

Es similar a un pequeño niño dibujando por primera vez, pero al revés. Un niño que sí puede ver, no maneja bien las palabras, pero desde el primer día su mente se ha llenado de imágenes. GPT nunca ha visto imágenes, pero desde el primer día ha estado repleto de palabras. Y los dos logran llegar a bocetos sencillos y abstractos, no muy fieles a la realidad, pero impresionantes para el nivel de información parcial que manejan (claro que al pobre GPT no le cuelgan los dibujos en el refrigerador).

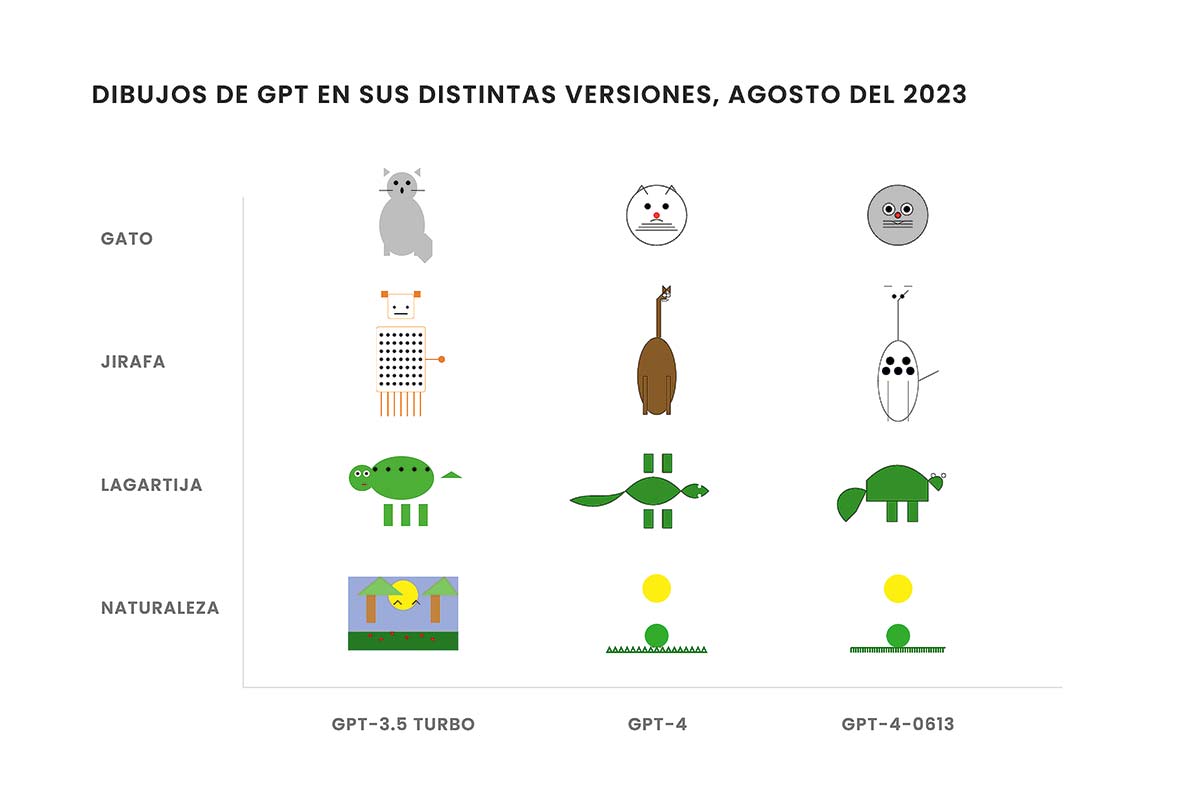

Sigamos con el test: los modelos anteriores apenas eran capaces de escribir un código que pudiese correr en un computador, no dibujaban nada. En cambio, GPT-3.5 y GPT-4 (que se lanzaron en marzo) no sólo generan código entendible y muy lógico, sino que al graficarlo vemos claramente la imagen solicitada, tal cual ese niño que hace bocetos por primera vez.

Esto ha llevado al “benchmark del unicornio”, donde la calidad del dibujo de ese ser mítico pone en evidencia la capacidad espacial y de abstracción del modelo.

Un dato curioso: en este experimento, con el tiempo, el dibujo del unicornio sólo iba mejorando, hasta que empezó a decaer. Quería decir que el modelo estaba avanzando en su “inteligencia” de convertir palabras y abstracciones en figuras específicas distribuidas en un plano… hasta que el unicornio empezó a deformarse.

Y justo coincidió con que OpenAI estaba ajustando GPT-4 para que fuera más seguro, lo que probablemente bajó su capacidad creativa e intuición. Por eso es un buen benchmark. Si quieres ver cómo va el modelo en su ocurrencia, pídele un unicornio.

¿Por qué importa el test del unicornio?

Son este tipo de habilidades las que hacen de modelos como GPT una pieza fundamental en todo lo que se viene. Su gracia no radica en poder darte información y responder preguntas, porque es imposible verificar la veracidad de lo que dicen (fenómeno conocido como “alucinaciones”). Más bien su don es tener la capacidad de planificar e invocar el uso de herramientas complejas, y usarlas de manera sofisticada.

Los modelos de texto no estaban hechos para dibujar, pero pueden hacerlo. Son estas las habilidades que permiten conectar a estos modelos con bases de datos y sistemas de información para crear servicios. Y el experimentar para ver “qué más puede hacer” además de sólo escribir, va a ser clave a medida que los modelos crezcan. Hay que seguir dibujando unicornios.